2025年4月29日,国际人工智能领域顶级会议The 34th International Joint Conference on Artificial Intelligence(IJCAI2025)论文录用结果揭晓,MMRC实验室团队在联邦分布外泛化、因果图像表示、异构模态扩散对齐方向的成果共计三篇论文被该会议录用。会议计划于2025年8月16日至8月22日在加拿大蒙特利尔举行。IJCAI会议是人工智能领域的重要学术会议,被中国计算机学会评定为A类学术会议。这次会议共收到5404篇有效投稿,录用率约19.3%。

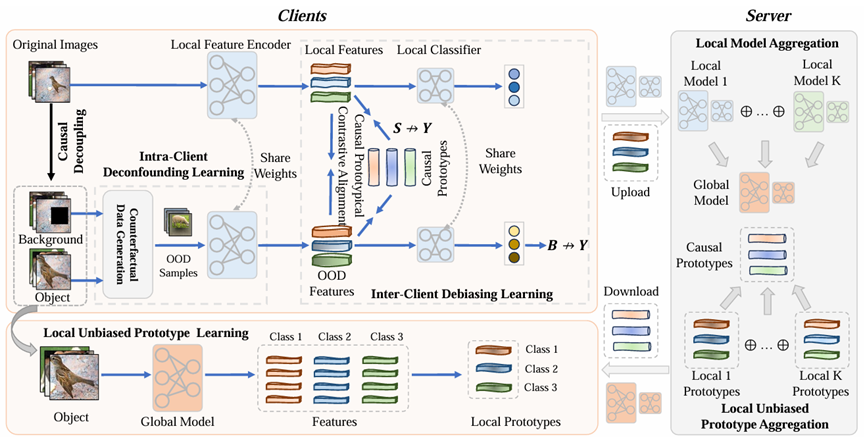

论文名称:Federated Deconfounding and Debiasing Learning for Out-of-Distribution Generalization

论文作者:齐壮(山东大学),周思锦(莫纳什大学), 孟雷∗(山东大学), 胡晗(北京理工大学),于涵(南洋理工大学),孟祥旭(山东大学)

论文简介:联邦学习中的属性偏差通常导致局部模型优化不一致,从而导致性能下降。现有方法通过使用数据增强或知识蒸馏来增加样本多样性,以解决学习不变表示的问题。然而,它们缺乏对推理路径的全面分析,并且来自混杂因素的干扰限制了其性能。为了解决上述限制,我们提出了一种名为“联邦去混淆与去偏学习”的方法(FedDDL)。如下图所示,该方法聚焦于影响数据与模型推理的关键变量,包括数据来源、背景、图像、目标对象以及标签等因素,并基于结构因果模型进行建模。具体而言,该方法首先在客户端内部将图像中的背景与目标对象进行解耦,并通过生成反事实样本来建立背景与所有类别之间的关联关系,同时不在联邦学习客户端之间共享任何样本信息。此设计确保了模型不会将背景错误地识别为因果因素,从而增强了模型在去混淆建模过程中的鲁棒性。另一方面,该方法通过仅利用图像中的目标对象来构建因果原型,而非使用完整的原始图像,这种做法有效降低了原型中特定属性的比例。进一步地,将这些因果原型视作跨源表示对齐的模板,鼓励各客户端的本地模型更加关注图像中的关键目标对象,而非背景内容,从而推动联邦学习环境下各个客户端之间学习统一的表示空间。这种机制不仅提升了模型的泛化能力,也有助于缓解由于数据异质性带来的性能偏差。大量的基准数据集实验表明,FedDDL显著提高了模型在多个新目标物体上的能力,平均提高了9个最先进模型的Top-1准确率达到4.5%。

图:FedDDL框架图

Paper链接:

https://arxiv.org/abs/2505.04979

Code链接:

https://github.com/qizhuang-qz/FedDDL

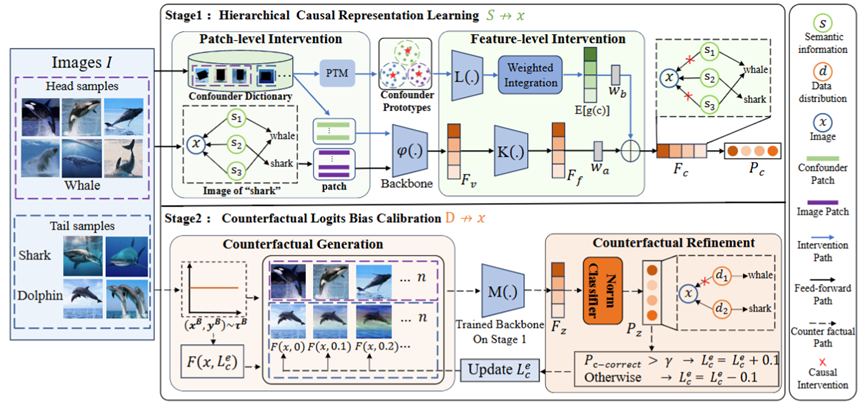

论文名称:Empowering Vision Transformers with Multi-Scale Causal Intervention for Long-Tailed Image Classification

论文作者:闫晓硕(山东大学),李照川(浪潮软件科技),孟雷*(山东大学),齐壮(山东大学),吴畏(山东大学),李子璇(山东大学),孟祥旭(山东大学)

论文简介:因果推断通过消除由类别不平衡引发的偏差,在缓解长尾分类问题中展现出显著潜力。然而,随着视觉模型架构由传统卷积神经网络(CNNs)逐渐演进至视觉Transformer(ViT),现有因果推断方法在新架构上的适用性和有效性面临挑战。本文系统分析了因果方法在CNNs与ViT架构中的差异性表现,发现ViT所具有的全局特征建模机制削弱了因果方法建立细粒度目标与分类预测之间因果关联的能力,导致语义相近的长尾类别难以有效区分,进而影响模型对尾部类别的识别性能。为解决上述问题,本文提出TSCNet,一种基于多尺度因果干预的双阶段因果建模框架。具体而言,在分层因果表示学习阶段,TSCNet通过显式建模图像中目标区域与背景区域的结构化差异,在图像块层级与特征空间层级分别引入后门干预操作,阻断模型对类别无关区域的依赖路径,从而提升模型对细粒度因果特征的感知能力;在反事实逻辑偏置校准阶段,TSCNet设计了一种自适应反事实样本生成策略,构造更加均衡的训练分布,以优化模型在长尾分布下的决策边界,并有效缓解因样本稀缺而引发的预测伪相关问题。在多个标准长尾分类基准上进行的大量实验证明,TSCNet不仅在整体精度上超越现有主流方法,在尾部类别上取得了更显著的性能表现,验证了其在复杂分布下建模多重偏差的有效性与泛化能力。

图:TSCNet框架图

Paper链接:

http://arxiv.org/abs/2505.08173

Code链接:

https://github.com/stu-xsy/TSCNet

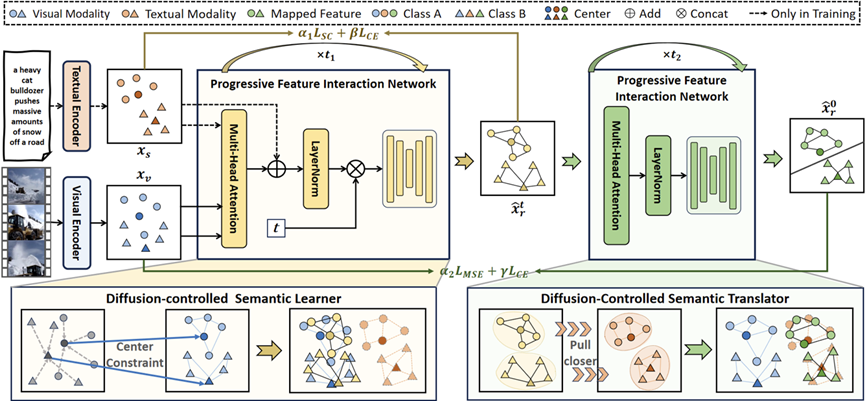

论文名称:Semantic-Space-Intervened Diffusive Alignment for Visual Classification

论文作者:李子璇(山东大学),孟雷*(山东大学),晁国清(哈尔滨工业大学), 吴畏(山东大学), 杨一萌(山东大学),闫晓硕(山东大学),齐壮(山东大学),孟祥旭(山东大学)

论文概述:跨模态对齐是一种提高视觉分类效果的有效方法,通过有效的跨模态对齐,可以使得不同模态的数据(如图像和文本)能够在共享语义空间中进行相互映射,从而提升模型对复杂任务的处理能力。然而,现有的方法通常通过强制的单步映射,将视觉特征投射到文本特征分布的空间。这种映射方法虽然简单,但常常面临类别样本分布差异和特征值范围不一致的问题,导致现有方法在找到有效投射时存在困难。这些问题使得跨模态对齐效果不理想,限制了视觉分类等任务的进一步提升。为了解决这个问题,本文提出了一种语义空间干预的扩散对齐方法(SeDA)。考虑到两种模态的特征在分类中共享相同的类别级信息,SeDA将语义空间作为视觉到文本投射中的桥梁。此外,SeDA还提出了一个双阶段扩散框架,实现两种模态之间的渐进式对齐。具体而言,SeDA首先利用扩散控制语义学习器,通过约束扩散模型的交互特征与视觉特征的类别中心,建模视觉特征的语义空间。随后,在SeDA的后续阶段,扩散控制语义翻译器专注于从语义空间中学习文本特征的分布。同时,渐进式特征交互网络在每一步对齐过程中引入渐进特征交互,逐步将文本信息融合到映射特征中。实验结果表明,SeDA在多个场景下实现了更强的跨模态特征对齐,相比现有方法,表现出显著的性能提升。

图:SeDA框架图

Paper链接:

https://arxiv.org/abs/2505.05721

Code链接:

https://github.com/bigwahaha/SeDA